时间定格至2032年。前洛杉矶警察局警官John Spartan在冰封沉睡三十年后醒来,发现周围的一切都发生了变化,包括驾驶技术。

在1993年上映的电影《超级战警》中,几乎所有的汽车都是无人驾驶,当然这些都是概念汽车。如今,十多家汽车制造领导品牌(包括奥迪、宝马、通用、特斯拉、大众和沃尔沃)都在研发无人驾驶技术。此外,谷歌已经开发了定制汽车,目前累积行驶距离超过100万英里(相当于美国一个成年人驾驶75年)且没有发生任何重大事故。

这些成就着实令人惊叹,但很多人不禁又问:“还得多久才能普及无人驾驶汽车呢?”

汽车食物链错综复杂,包括半导体供应商、系统集成商、软件开发人员和汽车制造商,而Imagination Technologies则将其自身定位在这条食物链开端的独特位置。只有食物链下的所有企业密切合作、共同开发底层ADAS(高级驾驶员辅助系统)技术,才能引导市场走向无人驾驶汽车商用化的发展之路。

目前,实现ADAS功能有三大主要方法:

第一个方法便是存储大量的地图数据,然后在给定的环境中进行导航。但这个方法通常被认为像一辆火车行驶在隐形的铁轨上。该方法的案例便是谷歌的无人驾驶汽车。其基本上只使用一组预先录制好的街道高清地图进行导航,传感技术使用极少。在这种情况下,汽车仅依靠高速连接和传感器聚合来维持一个固定的链接到提供了导航坐标的云巨型结构中。

相比之下,另一种方法便是依靠计算机视觉处理,且没有使用预先录制好的地图信息。这种方法相当于复制了一个人类驾驶员,因为汽车能够基于丰富的传感器和高性能处理器进行实时决策。通常,这一类汽车含有多个相机以获得广角视图,并使用专用的高性能、低功耗芯片,以实现超级计算机的处理能力来进行ADAS硬件和软件算法。

首创这一方法的公司是Mobileye,其有专门为全自动汽车设计的强大的高能效EyeQ SoC。例如,最近,处理公路自动驾驶功能需求的基于MIPS的Mobileye EyeQ3 SoC已在特拉斯汽车上使用。这种情况中,Mobileye一直使用多核多线程MIPS I级CPU来处理来自汽车各个摄像头的数据流。

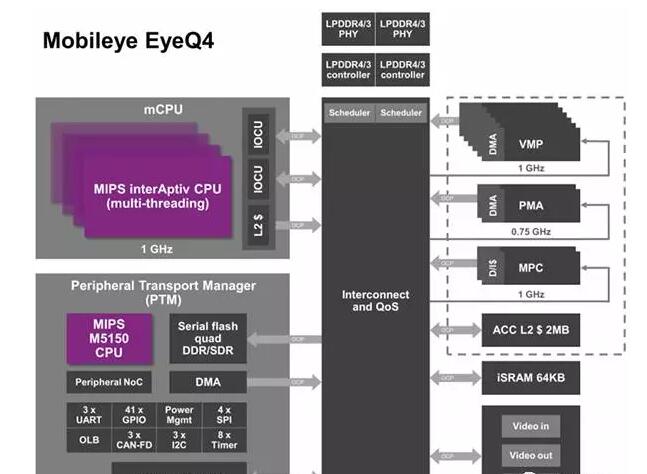

下图中,EyeQ4 SoC内的四核四线程interAptiv CPU用作芯片的主体,引导来自摄像机及其他传感器的信息流进入右边VLIW 表示的2.5 TFLOPS处理快中。

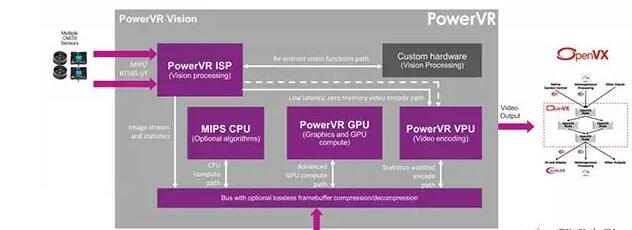

最后,第三大趋势便是再度启用全自动驾驶通用SoC处理器。对于已配备了用于资讯娱乐的嵌入式GPU的汽车,开发人员可以充分利用进行运算的图像引擎计算资源来对车道、行人、车辆、建筑物、停车场等进行识别和跟踪。例如,Luxoft的计算机视觉和增强现实技术解决方案使用了PowerVR图像框架及附加软件来实现ADAS功能。用于嵌入式基于PowerVR硬件的软件框架可以快速有效地实现自动驾驶功能。

为解决下一代全自动汽车应用程序的需求,Imagination最近发布了PowerVR Series7——实现了10位支持和硬件虚拟化的GPU系列,这对于 ADAS开发人员而言是两大重要的功能。GPU内的10位色彩深度使汽车制造商可以构建高精度的采集与显示管道,包括图像传感器、视频编码器/解码器及图像引擎。

相比传统的8位解决方案,10位多媒体子系统可以更精确地检测车道、道路交通标志或其他标记。实现硬件虚拟化则可以在单个的设备中可靠安全地运行两个或三个应用程序。例如,集成了MIPS军工级 CPU及PowerVR Series7 GPU的SoC可以同时在同一个芯片上优化执行Rightware Kanzi UI资讯娱乐集群和Luxoft ADAS方案,且二者的性能和可靠性都为最佳。

不管使用何种方法,无人驾驶汽车都为汽车公司、传感器供应商和半导体行业展示了广阔的前景。这得益于具有硬件内存管理、多线程和虚拟化功能的先进的SoC模块和高性能微控制器。这些功能使得OEM可以实现更复杂的软件应用程序,包括基于模型的过程控制、人工智能和先进的视觉计算。

很开心看到Imagination及其合作伙伴在2016年及未来开发全自动驾驶软硬件解决方案方面能扮演如此重要的角色